Как пользователи воспринимают новости, сгенерированные искусственным интеллектом?

Навигация по статье

- 1 Скрытое авторство искусственного интеллекта: разоблачения и скандалы

- 2 Открытое указание ИИ-авторства: прозрачность и реакция

- 3 Нейроавторы выходят из тени, но этого недостаточно

- 4 Споры о транспарентности использования ИИ

- 5 Доверие аудитории к ИИ-сгенерированным новостям

- 6 Психологические эксперименты о восприятии искусственного интеллекта

- 7 Готова ли аудитория принимать искусственный интеллект в публикациях?

В последние годы медиа всё чаще экспериментируют с генеративным искусственным интеллектом (ИИ) для создания текстов. Сами по себе такие тексты выглядят вполне правдоподобно. Технологии аналогичные ChatGPT научились писать связно и грамотно, пусть и несколько шаблонно. Поэтому если специально не указать, что автор использовал искусственный интеллект, читатель может прочитать ИИ-новости и не заметить подвоха.

Однако более пристальное изучение таких материалов нередко выявляет ошибки или нелепости, выдающие их искусственное происхождение. В ряде случаев именно на этом и основывались разоблачения, всколыхнувшие медиаотрасль.

Готовы ли мы доверять новостям, если знаем, что их написал не человек, а алгоритм? Это исследование подробно рассматривает реакцию аудитории, анализирует громкие скандалы и примеры прозрачного использования ИИ.

Скрытое авторство искусственного интеллекта: разоблачения и скандалы

Скандал вокруг Cnet

Яркий пример скрытого ИИ-авторства — известный технологический сайт CNET, который в конце 2022 года начал тихо публиковать статьи, полностью сгенерированные искусственным интеллектом. Материалы на финансовые темы выходили под обобщённым авторством «CNET Money Staff», и лишь при наведении курсора на имя автора открывалась сноска: «статья подготовлена с помощью автоматизированных технологий».

Руководство сайта изначально не афишировало эксперимент, пока интернет-энтузиасты не обнаружили подвох. Разоблачение повлекло за собой цепочку неприятных открытий. Выяснилось, что более половины автоматических статей CNET содержали фактические ошибки. Так, в одной из них неверно вычислялись проценты по вкладам — ИИ написал, что депозит в $10 000 под 3% принесет $10 300 через год, хотя на самом деле прибыль составила бы лишь $300. В результате CNET пришлось публиковать десятки исправлений: по данным издания The Verge, правки были внесены в 41 из 77 ИИ-сгенерированных материалов.

Более того, анализ показал, что алгоритм частично позаимствовал фразы из чужих текстов. Таким образом фактически свершился непреднамеренный плагиат.

Данная история вызвала большой резонанс: в СМИ открыто заговорили о том, что роботы-журналисты пока не готовы конкурировать с живыми — они делают ошибки. А их якобы «авторитетный» тон может усыплять бдительность редакторов.

Случай Sports Illustrated

Другой громкий случай произошел с журналом Sports Illustrated (SI) в конце 2023 года. Выяснилось, что на сайте издания публиковались статьи под именами несуществующих авторов и с фальшивыми фото, сгенерированными нейросетью. Псевдо-авторы писали шаблонные обзоры, неуклюжий язык которых сразу вызвал подозрения. Два источника внутри проекта подтвердили прессе, что тексты генерировались ИИ.

После огласки компания, владеющая журналом, поспешно удалила спорные материалы и заявила, что они были предоставлены неким сторонним «контент-провайдером». Руководство отрицало систематическое использование ИИ, но репутационный удар состоялся. Журналисты и читатели восприняли практику как обман аудитории.

Подкаст «Честно говоря»: Искусственный интеллект — перспективы и риски

Несуществующее интервью с Шумахером

Весной 2023 года немецкий журнал Die Aktuelle опубликовал «эксклюзивное интервью» с легендарным гонщиком Формулы-1 Михаэлем Шумахером. Тот с 2013 года из-за тяжёлой травмы находится под опекой семьи и не общается с прессой. Таким образом, интервью должно было стать первым за долгие годы болезни. На обложке журнала красовался Шумахер и заголовок: «Первое интервью: оно звучит правдоподобно». Лишь внутри мелким шрифтом пояснялось, что все цитаты генерировались искусственным интеллектом.

Реакция была мгновенной и крайне негативной: семья Шумахера заявила о намерении подать в суд. Издатель немедленно уволил главного редактора журнала Die Aktuelle, публично извинившись за эту «безвкусную и вводящую в заблуждение статью».

Расследование NewsGuard

Отдельно стоит упомянуть расследование, выявившее целую сеть фейковых новостных сайтов, полностью наполненных текстами от ИИ. Аналитическая компания NewsGuard в 2023 году обнаружила 49 ресурсов, маскирующихся под новостные, но почти целиком генерируемых ботами.

На этих сайтах в день выходило до сотни материалов с характерными признаками машинного языка — сухими, повторяющимися предложениями. Попадались даже курьёзные остатки промтов: некоторые «статьи» содержали фразы «I cannot complete this prompt as it goes against OpenAI’s use case policy…» — явно сгенерированные ChatGPT и не удаленные редактором.

Эксперты называют подобное явление фабриками контента и предупреждают: если не бороться, ложная информация, сгенерированная ИИ, может перерабатываться другими ИИ, порождая замкнутый цикл фейковых новостей. Пользователи, случайно наткнувшиеся на такой сайт, могут не сразу понять, что перед ними синтетический контент — и риск дезинформации возрастает.

Как искусственный интеллект помогает распространять дезинформацию

Открытое указание ИИ-авторства: прозрачность и реакция

Не все издатели шли по пути сокрытия. Были и обратные примеры, когда факт использования искусственного интеллекта открыто декларировался — либо с самого начала, либо после критики, в попытке вернуть доверие. Однако и такой подход не всегда встречал понимание аудитории.

Кейс Iconic Media

Летом 2023 года ирландская медиа-группа Iconic Media опубликовала в своих региональных онлайн-газетах провокационную колонку под заголовком «Мнение: Должны ли беженцы вернуться домой?» В этом случае издатель честно отметил авторство: прямо в байлайне (строке с именем автора) значилось «AI Generated». Более того, в начале текста стояло явное предупреждение: «Примечание: эту статью написал ChatGPT — чат-бот с искусственным интеллектом. Ему был задан вопрос: должны ли беженцы в Ирландии ехать домой?»

Казалось бы, полная прозрачность — читателю сразу дают понять, что перед ним экспериментальный материал от машины. Однако реакция журналистского сообщества оказалась негативной. Национальный союз журналистов (NUJ) выразил по этому поводу «крайнюю обеспокоенность». Представитель союза заявил, что такая публикация демонстрирует ограничения ИИ в плане качественного анализа и ответственности: живой журналист при подготовке такого материала изучил бы контекст, поговорил бы с реальными людьми, привёл факты и истории. Всего этого ИИ не сделал.

Iconic Media вскоре изменила заголовок на более нейтральный — «Можно ли доверять искусственному интеллекту?» — и добавила пояснение, что это пример AI-контента для обсуждения. Однако осадок остался: аудитория и журналисты отнеслись к попытке использовать бота для освещения чувствительного вопроса настороженно.

И снова CNET

Другой пример открытой маркировки ИИ-авторства пришелся на уже упомянутый CNET — правда, только после скандала. Столкнувшись с критикой, редакция изменила прежнюю скрытную подпись «CNET Money Staff» на более понятную. Теперь под заголовком стояло уведомление: «данная статья создана при помощи ИИ-движка и тщательно отредактирована сотрудником нашей редакции». То есть издание сделало акцент, что роль человека — в проверке фактов и правке текста — сохраняется.

Дипфейки в политике: Восточная Европа, Китай, Индия

Нейроавторы выходят из тени, но этого недостаточно

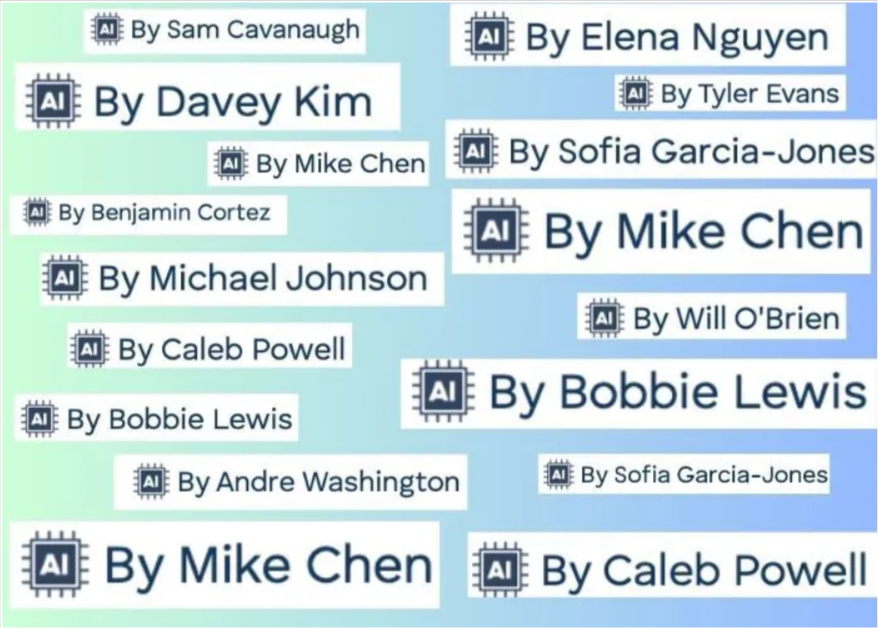

Похожим на CNET путём пошли и другие проекты. Так, гиперлокальный новостной сайт Hoodline (США), который уличили в массовом наполнении городских хроник через ИИ, тоже внедрил специальные значки возле имён авторов. Теперь почти у каждого материала на Hoodline стоит небольшая иконка «AI» рядом с именем автора. Фактически это признание, что текст сгенерирован машиной. На сайте остались лишь два реальных корреспондента, все прочие «журналисты» — вымышленные профили. Портал также поместил специальное пояснение в разделе Disclaimer.

Примечательно, что Hoodline добавил эти плашки лишь после давления со стороны коллег. Конкурирующее местное издание напрямую спросило, использует ли Hoodline ИИ. Только тогда компания пошла на раскрытие информации.

Тем не менее, такой запоздалый шаг мало помог репутации — аудитория уже чувствовала себя обманутой. Эксперты отметили, что простого значка «ИИ» рядом с автором недостаточно: он не даёт читателю детального понимания, какую роль играл алгоритм, и была ли проведена должная проверка фактов.

Тренды соцсетей: интерес и доверие к новостям падает

Споры о транспарентности использования ИИ

Сегодня во многих редакциях сходятся во мнении, что прозрачность при использовании искусственного интеллекта необходима. Крупнейшие новостные агентства и медиа-холдинги разрабатывают политики по использованию ИИ, где одним из ключевых пунктов значится открытое информирование аудитории.

Международные журналистские организации тоже выпустили рекомендации, призывающие четко раскрывать применение ИИ. Так, в Парижской хартии по ИИ и журналистике записано, что если в создании текста в значительной мере участвовал алгоритм, читатель должен об этом знать.

Редакции спорят о формулировках — указывать ли «написано ИИ», «написано при помощи ИИ» или уточнять долю вклада человека? Например, исследователи отметили разброс вариантов: одни пишут «совместно с ИИ», другие — «под редакцией человека», третьи вообще дают ИИ авторскую строчку. Все это призвано не запутать, а наоборот успокоить читателя, показать, что издание не выдаёт работу машины за человеческую и не снимает с себя ответственности за качество.

Доверие аудитории к ИИ-сгенерированным новостям

Готовы ли люди доверять новостям, написанным ИИ? Вопрос доверия к «машинным новостям» стал предметом многочисленных академических и отраслевых исследований. Их результаты неоднозначны, но позволяют выявить несколько ключевых тенденций.

Глобальный опрос Reuters Institute (Digital News Report 2024), охвативший почти 100 тысяч респондентов в 46 странах, выявил высокий уровень скептицизма в отношении к ИИ. Более половины опрошенных заявили, что им неприемлема идея новостей, создаваемых искусственным интеллектом. Например, в США так ответили 52% респондентов, в Великобритании — 63%. Особенно негативно люди относятся к применению алгоритмов в чувствительных темах — политике, социальных вопросах. В то же время использование ИИ «за кулисами» — для помощи журналистам, ускорения их работы — вызывает меньшие возражения.

Авторы отчёта отметили удивительно высокий уровень подозрительности: аудитория боится снижения надёжности новостей и утраты доверия, если в процесс вмешается машина. В том же исследовании 59% участников выразили тревогу из-за фейковых новостей в интернете. И появление генеративного ИИ только усиливает такие переживания.

Однако разброс мнений между разными демографическими группами тоже значителен. Молодёжь обычно относится к технологиям смелее. Например, в Ирландии доля тех, кто «вполне или очень комфортно» воспринимает новость, написанную ИИ (с некоторым участием редактора), за год выросла до 19% — и среди людей до 35 лет этот показатель почти вдвое выше, чем среди старшего поколения.

Около 5% ирландцев вообще признались, что уже получают часть новостей из чат-ботов (ChatGPT, Gemini, Zendesk, Tidio, Copilot и прочие). Похожая картина и в масштабе мира: глобально порядка 15–20% аудитории не возражают против ИИ-контента при наличии человеческого надзора. Остальные же либо колеблются, либо категорически против — в частности, считают, что ИИ неизбежно сделает новости менее достоверными и точными.

Цифровое медиапотребление в 2024 году: глобальные тренды и ключевые инсайты

Психологические эксперименты о восприятии искусственного интеллекта

Скептические общественные настроения в отношении ИИ подтверждаются и результатами психологических экспериментов. В 2024 году группа исследователей из Университета Канзаса провела любопытное испытание: людям показывали один и тот же новостной текст, но с разными вариантами подписи — от «Написано штатным корреспондентом» до «Написано искусственным интеллектом», включая комбинированные («написано журналистом с помощью ИИ» и т.п.). Оказалось, что сам факт упоминания ИИ в авторстве уменьшал восприятие достоверности. Читатели, увидевшие явное «написано ИИ», оценивали и надёжность источника, и качество сообщения ниже, чем те, кто думал, будто текст от человека.

Даже формулировка «с помощью ИИ» слегка подрывала доверие. Более того, многие участники эксперимента склонны были сами додумывать роль алгоритма: если им показывали подпись «Staff Writer» («штатный автор») без имени, некоторые воспринимали её как участие машинного автора. И чем больше, по их мнению, вклад ИИ в статью — тем ниже они ставили её в рейтинге правдивости.

Другими словами, люди ценят «человечность» в журналистике. В традиционно человеческой сфере — написании новостей — появление машин снижает уровень доверия. При этом в других областях, таких как рекомендации видео или музыки алгоритмами, подобного эффекта может и не быть.

Интересно, что участники всё же отмечали важность прозрачности. Хотя присутствие пометки «ИИ» снижало их оценку статьи, они одновременно говорили: лучше знать, если машина приложила руку к тексту, чем не знать вовсе.

Готова ли аудитория принимать искусственный интеллект в публикациях?

На основе опросов и исследований складывается парадоксальная ситуация. Аудитория требует от медиа честности и ответственности в вопросе ИИ, потому что ценит достоверность и человечность новостей. Сами медиа стараются нащупать баланс: не отпугнуть прогресс, но и не потерять читателей. Но полного доверия к роботам-журналистам пока нет — напротив, есть опасения. Тем не менее, постепенно формируется понимание, в каких жанрах и как ИИ может пригодиться (например, генерация коротких заметок о погоде или спортивной статистике), а где непременно необходим человек (аналитика, расследования, этически сложные темы).

Можем предположить, что будущее журналистики не за полной заменой людей роботами, а за гибридными моделями, где ИИ берёт на себя рутинные задачи (обработку данных, написание простых заметок), а журналисты фокусируются на расследованиях, аналитике и создании сложных, требующих эмпатии и критического мышления материалов. В этой новой реальности главным капиталом любого СМИ останется доверие, завоевать которое гораздо сложнее, чем просто сгенерировать текст.

Понравилась статья? Прочитай другие новости проверенные на фейк или обучись медиаграмотности сам_а!

Ищешь, где смотреть проверенные новости? Подпишись!